Чоң тилдик моделдер катачылыктарды факт катары көрсөтүүнү улантууда. Жаңы версиялар чыкканына карабастан, көйгөй жоголгон жок. Hackernoon маалыматына ылайык, 2025-жылдагы Vectara рейтингинде GPT-5тин ката деңгээли 1,4% болуп, GPT-4түн 1,8% көрсөткүчүнөн төмөн жана GPT-4o көрсөткөн 1,49%дан бир аз гана жакшыраак. Бирок медицинада, юриспруденцияда же психотерапияда эң кичинекей каталар да олуттуу кесепеттерге алып келиши мүмкүн, жазат InoZpress.

LLM галлюцинациясынын көйгөйү бир нече жолу байкалган: 2023-жылы Google’дун Bard модели James Webb телескобу тууралуу фактыларды бурмалап берген, кийин Google AI «минералдар үчүн таш жегиле» деп кеңеш берген, ал эми ChatGPT юристтерге алты ойдон чыгарылган ишти берген, натыйжада алар санкцияга кабылышкан. Мындай окуялар кызыктай угулганы менен, иш жүзүндө туура эмес жооптор өмүргө жана бизнеске түздөн-түз коркунуч жаратат.

Эмне үчүн моделдер галлюцинацияга кабылат

Негизги себеп тилдик моделдердин үйрөнүү табиятында жатат: алар фактыларды текшербестен, сөздөрдүн тизмегинде кийинки сөздү божомолдошот. Далилденген билим базасы жок болгондуктан, текст маалыматтардагы үлгүлөрдүн ыктымалдыгы менен түзүлөт. Маалымат жетишпей калганда, модель «кыялдангандай» жообун сунуштап коёт.

Узак убакыт бою маалымат булагы катары интернет колдонулуп келген — блогдор, форумдар, викилер. Бирок 2025-жылга карата интернеттин чоң бөлүгү өзү эле ИИ тарабынан түзүлүп калгандыктан, моделдер өз каталарынан үйрөнүп башташты. Натыйжада жаңылыш маалымат кайталанып, бурмалоо күчөйт.

Акысыз маалымат доорунун аякташы

2023-жылдан тартып ири платформалар өз маалыматтарына жеткиликти чектей башташты. Reddit акысыз API’ди кыскартты, Twitter/X толугу менен бекер мүмкүнчүлүктү жойду, LinkedIn маалымат жыйноого каршы эрежелерди катуулатты. Stack Overflow суроо-жоопторуна төлөм киргизди, ал эми Quora контентти Poe тиркемесине өткөрдү. Meta болсо Facebook жана Instagram’дагы маалыматтарды колдонууга чектөө киргизди.

Мунун натыйжасында колдонуучунун контентин акысыз колдонуу доору аяктады. Чоң AI-компаниялар лицензияланган маалыматка өтүштү, ал эми ачык моделдер эскирген жана «шумдуу» массивдер менен калды. Бул болсо башка ИИ жазган тексттерди кайрадан окуп-үйрөнүү коркунучун күчөтөт.

Лицензияланган маалымат рыногу

OpenAI 2023-жылы Associated Press менен келишим түзүп, кийин Axel Springer жана News Corp менен келишимдерге кол койгон. 2025-жылга карата аларга The Guardian жана The Washington Post сыяктуу жыйырмадан ашуун ири басылмалар кошулган. Google да 2025-жылы AP менен келишим түздү, Microsoft болсо Copilotту юридикалык суроолор үчүн Westlaw менен интеграциялады.

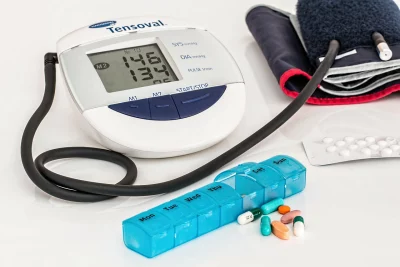

Лицензияланган маалымат рыногу 2024-жылы $3,2 млрд деп бааланган жана 2034-жылга карата $16,3 млрдга жетери күтүлүүдө. Бул тармакка жаңылыктар, академиялык архивдер, медициналык репозиторийлер, финансы маалыматтары жана өнөр жай маалыматтары кирет. Бирок көптөгөн булактар жабык бойдон калууда: The New York Times OpenAI жана Microsoftко каршы доо койгон, Elsevier жана Wiley илимий архивдерин ачыкка чыгарган эмес.

Таза резервуарлар кайда түзүлүп жатат

Тармактык маалымат кампалары жаңы стандартка айланууда. Жаңылыктар жана басма дүйнөсүндө — AP, Axel Springer, News Corp, The Guardian, Vox Media. Академиялык чөйрөдө — Harvard, MIT, arXiv жана Semantic Scholar сыяктуу ачык репозиторийлер. Медицинада — ScaleMAI жана DR-AIR сыяктуу атайын курулган маалымат топтомдору. Финансыларда — BloombergGPT жана Thomson Reuters.

Бул резервуарлар катуу фильтрация, текшерүү жана жеткиликтүүлүктү көзөмөлдөө менен айырмаланат. Алар компанияларга ИИни кокусунан интернеттен алынган маалыматка эмес, далилденген маалыматка таянуу менен курууга шарт түзөт.

Каталардан сактануу жолдору

Ачык моделдер менен иштеген колдонуучулар үчүн негизги эрежелер маанилүү:

- суроону мүмкүн болушунча так берүү;

- маалымат булагын чектеп, модель ошол эле булактан гана жооп бериши керектигин белгилөө;

- ойдон чыгарылган фактыларга тыюу салуу;

- даталар, аттар жана сандарды кошумча булак аркылуу текшерүү;

- ийгиликтүү промпт үлгүлөрүн сактап, кайра колдонуу.

Мындай ыкмалар галлюцинация тобокелдигин азайтып, жоопторду фактылар чегинде сактоого жардам берет.

Биз буга чейин жазганыбызды эскертебиз, жасалма интеллект тармагындагы пайда бөлүшүү келишимдери дүйнөсү.